1 L’Orienté Objet, Qu’est-ce que c’est ?

1.1 Contexte

Afin de bien comprendre ces enjeux, il nous a semblé important de retracer quelques étapes importantes du son, jusqu'à nos utilisations et besoins actuels, avant d’appréhender le concept de l’Audio Orienté Objet.

En 1932, suite à l’invention de la stéréophonie par l’ingénieur Alan Blumlein un an auparavant, le brevet de Gance-Derbie sur la projection sonore à haut-parleur multiple est déposé. La musique au cinéma est alors interprétée en direct, tandis que les dialogues et effets sont sur deux pistes optiques. L’enceinte dédiée avait comme avantage une bonne intelligibilité des dialogues, en plus d’une cohérence à l’image. Mais un technicien doit opérer manuellement la bascule afin d’avoir les dialogues à l’arrière de l’écran et les effets en surround.

“La tâche incombant à l’opérateur étant fastidieuse, les techniciens s’accordèrent sur le fait qu’il était tout à fait acceptable d’avoir conjointement, les dialogues et la musique d’orchestre, diffusés en un seul et même point derrière l’écran. Cette anecdote du début du cinéma parlant, entraine par son échec les prémisses du mixage orienté canal, alors qu’il constitue sans le savoir les fondements du mixage orienté objet.”

( Extrait de “L’Approche Orienté Objet” mémoire de Florent Denizot, école Louis Lumière, 2016, p.16)

Statue Walt Disney

Puis le film Disney “Fantasia” en 1940, marqua à son tour l'histoire du cinéma sonore, car ce fut le premier film commercialisé en son stéréo (et multicanal).Mécontent de la qualité sonore de l’époque, Walt Disney voulait créer un film plongeant le spectateur dans la scène sonore, comme étant à la place d’un chef d’orchestre, avec des sons se déplaçant à travers la scène.

Les ingénieurs de Disney et de Bell Labs ont souhaité enregistrer l’orchestre de Philadelphie avec trente-trois microphones, et neuf enregistreurs. Avec ces nombreuses pistes, le mixage fut vite un problème pour rendre le tout réaliste et la diffusion fut impossible avec la contrainte du nombre de piste sur la bande. Les neuf pistes ont finalement été combinées en quatre; trois pour la voix, la musique, les effets spéciaux; et une quatrième pour le contrôle du volume des trois premières. Le son avait donc sa propre bande, séparé de l’image.

La diffusion a également été étudiée, basée sur trois enceintes à l’arrière de l’écran et deux sur les côtés, qui rediffusaient les signaux des enceintes droite et gauche. Les ingénieurs ont découvert que le fait d'éloigner des enceintes entre elles permettait le déplacement du son, sans que celui ci ne disparaisse entre les enceintes. Cet effet de déplacement dans la scène sonore ne pouvait pas se limiter à un contrôle de volume. Le potentiomètre panoramique a donc été créé, permettant le mouvement fluide du son d’une enceinte à une autre.

Le concept a donc été créé pour le film, et Fantasia reposait réciproquement sur l’aspect technique de diffusion, chaque salle devait donc être équipée, afin qu’il soit bien restitué. Les différentes installations en salle se sont révélées coûteuses et ont considérablement augmenté les coûts de production. La distribution sous le procédé Fantasound s’est alors réduite, et a entraîné l'échec commercial, malgré un concept innovant.

Après la découverte du son magnétique et de la projection Cinerama, le CinémaScope voit le jour en 1952, créé par la FOX, et connaîtra plusieurs normalisations de la SMPTE (Society of Motion Picture and Television Engineers). L’image s’agrandit grâce à l’anamorphose créé avec l’hypergonar (optique devant le projecteur) afin de concurrencer la télévision, le son se doit de rester cohérent.

Quatre pistes magnétiques sont alors insérées (sur la même bande magnétique 35mm dédiée à l’image) avec trois canaux (gauche, centre, droite), et un canal d’ambiance. Le 70mm utilisera par la suite six canaux, cinq pour l’écran un pour l’ambiance.

Après le Dolby A très utilisé pour la réduction du bruit au cinéma dès 1966, la société confirme sa place en 1977 avec le Dolby Stéréo, permettant à l’aide d’un matriçage, d’obtenir quatre canaux avec seulement deux pistes optiques sur la bande. Les contraintes liées à la bande sont ainsi réduites, ce procédé remplaça les précédents , le magnétique étant plus simple, et moins coûteux.

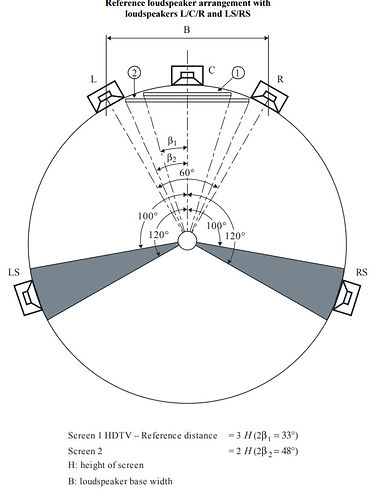

La disposition des enceintes reste la même au fil du temps depuis le CinémaScope, normalisé en 1987 par la SMPTE sous la proposition de l’ingénieur Tomlinson Holman. Trois à cinq enceintes sont disposées à l’arrière de l’écran, quelques unes sur les côtés de la salle, et une dernière pour les basses fréquences (système 5.1 ou 7.1). Les enceintes L et R sont à 30° par rapport à l’enceinte centrale, et à 110° pour les enceintes surround Ls et Rs selon la norme ITU-R BS 775-1 (image ci-dessous).

ITU-R BS 775-1

C’est également en 1987 que le Dolby Pro Logic, utilisant la technologie Dolby surround, est introduite sur le marché grand public. De part le home cinéma, la télévision continue de faire concurrence. Les supports se développent avec la VHS, le DVD, puis le Blu-Ray, et les technologies Cinéma des grandes entreprises Dolby et DTS sont de plus en plus disponibles (jeux vidéo, films, télé) ce qui élargit les utilisations du son multicanal et accroît la qualité. L’image évolue également dans les années 2000, avec l’arrivée de la HD qui bouleverse l’audiovisuel, la vente de télé écran plat augmente, Internet est démocratisé et les smartphones affluent. Le mode de consommation des contenus audiovisuel change.

Parallèlement, le cinéma remodèle sa chaîne de production progressivement et s’adapte au numérique. Le film, le son, les sous-titres, les données, sont encapsulés dans un conteneur appelé DCP (Digital Cinéma Package). Le DCP sécurisé est ensuite transmis aux exploitants de salles par internet, ou physiquement (disque dur). Après avoir chargé le film dans le projecteur numérique, l’opérateur intègre la KDM, une clé sous forme de fichier codé permettant la diffusion du film en un temps défini (appelé aussi Key Delivery Message). Après maturation, cette technologie permet une meilleure qualitée visuelle et sonore, plus stable et durable. Les problèmes liés à la pellicule comme la casse, les erreurs de montage des bobines, ou encore les limites d’inscriptions d’informations liées à la taille de la bande sont révolues. La projection numérique n’est toutefois pas dispensée de problèmes techniques comme la reconnaissance des clés. La gestion des KDM peut aussi devenir un véritable casse tête, avec les différentes versions d’un film nécessitant chacune une sécurité.

Suite au 5.1 standard, plusieurs propositions de normes ont vu le jour comme le 10.2 par Thomlinson Hollman dans les années 90 (Fondateur de THX), dans les années 2000 le 22.2 de Hamasaki (ex ingénieur de NHK) ou encore l’Auro 3D en 2006.

Le format 7.1 sorti en 2010 par Dolby, est le premier résultat des recherches de la société sur un renouveau du format multicanal, voulant une progression sonore en lien avec les progrès visuels 3D et ainsi, relancer la vente des places de cinéma. Cette petite avancée marquée par la diffusion du film “Toy Story 3” de Pixar, symbolise surtout l’envie de révolutionner la spatialisation cinématographique. Mais Dolby atteint les limites du DCP avec un nombre de seize canaux maximum utilisables, autres versions comprises (langues,...), contrairement aux autres formats multicanaux utilisant des décodeurs et moteurs de rendu. La société Immsound proposera en 2012 une nouvelle approche, celle de l’audio Orienté Objet que nous étudierons, et qui donnera naissance par la suite au Dolby Atmos.

La pluralisation des normes, et des types de diffusion, sont au détriment du mixeur. Ces multiples supports suscitent plusieurs déclinaisons du format original, qu’opère le technicien, afin de correspondre aux mieux aux conditions dans lesquelles sera le spectateur. Le mixeur fait tout son possible afin de préserver les intentions sonores du film, tout en prenant en compte les contraintes (stockage DVD, norme de diffusion TV,...) qui obligent une certaine baisse de qualité du contenu. Pour la sortie d’un film, plusieurs exports doivent être ainsi effectués lors du mastering, selon le type de diffusion et du support. Avec le format original 5.1 PCM .WAV non compressé s’ajoute:

-

une version Dolby SR-D (Format numérique optique avec une compression AC-3, utilisé pour le stockage)

-

une version Blu-Ray (5.1 ou 7.1 avec les deux codages standards Dolby True HD et DTS Master HD)

-

une version DVD (5.1 compressée aux formats Dolby Digital AC-3 ou DTS)

-

une version diffusion TV (similaire au DVD avec un passage à 25 images par seconde)

-

Et enfin, une version Stéréo pour le DVD, Blu-Ray, TV (par exemple, le Dolby Digital 2.0, le PCM Stéréo ou le MPEG-2).

Le downmix 5.1 vers stéréo est délicat, les conditions différentes du salon mènent à réfléchir sur l’adaptation de différents éléments techniques mais aussi artistiques d’un contenu. L’acoustique bruyante et réverbérante implique une diminution de la dynamique audio, or elle est un élément essentiel à la mise en scène du film. Les effets doivent être contrôlés, et leur diffusion vérifiée car à contrario d’utiliser le canal LFE seulement pour les FX en salle de projection, le home cinéma dédie le canal de basses à tout le bas du spectre (en dessous de 150Hz environ) afin de restituer les fréquences ne pouvant pas être diffusées par les petites enceintes.

Enfin, la réduction de l’espace sonore et la concentration des composantes du film (musique, ambiance, reverb, effet,...) compliquent le mix, les dialogues peuvent alors moins trouver leur place et affecter la compréhension des voix.

Ces points doivent recevoir une attention particulière, complexifient le mastering, et peuvent aussi conduire à une diminution de l'expérience à la maison. L’engouement des salles de cinéma est donc encore bien là, malgré la sévère concurrence de l'expérience cinématographique à la maison (VOD, SVOD, Télévision,...). Elles se différencient nettement avec les conditions techniques optimales et une expérience authentique impossible à reproduire à l’identique chez soi (ambiance de la salle, chronologie des médias, acoustique, taille de l’écran, qualité sonore,...).

La production audiovisuelle mondiale n'a jamais été aussi diversifiée et importante quantitativement qu’aujourd’hui.

Nous sommes en pleine guerre des plateformes de vidéo à la demande avec Amazon Prime, Disney+, AppleTV+, Hulu, HBO max, ou encore My Canal, qui concurrence le géant Netflix. A contrario d’obliger bon nombre de spectateurs à faire un choix sur leurs abonnements pour une question de prix; le nombre et la qualité des contenus augmentent, ainsi que le budget (plusieurs centaines de millions de dollars pour des séries) afin de séduire et fidéliser les clients des plateformes. Le leader à ce jour Netflix, dénombre environs 167 millions d’abonnés.

Le binaural désormais bien connu du monde de l’audio, est de plus en plus utilisé (podcasts, parcours sonores). Cette technique d’écoute plus naturelle joue avec les fonctions de transfert de la tête (HRTF) qui permettent la localisation du son. Elle donne plus de plans sonores (3D) que la simple stéréo (2D), et cela à la portée de tous, simplement avec un casque audio. Le succès des ventes de ce dernier ainsi que la forte utilisation de téléphone, tablette, et ordinateur, augmentent donc le nombre potentiel d’auditeurs.

Avec un début timide, la Réalité Virtuelle (VR) se démocratise, et voit son champs d’action s’agrandir (Culture, Formation, Sciences, Cinéma,...) en plus du jeu vidéo. Afin d’avoir un univers immersif cohérent, la partie sonore se devait elle aussi immersive et interactive. La technique binaurale est alors la mieux adaptée pour ce nouveau contenu, pouvant s’adapter aux mouvements de tête de l’utilisateurs, captés à l’aide d’un Head Tracker.

Jusqu'à présent, chaque contenu est créé pour une diffusion particulière (cinéma, podcast, télé…) et se voit attribuer un format principal. Cela implique de réadapter le contenu pour chaque situation voulue, aussi nombreuses soient-elles. En définitive, cela prend du temps, et augmente le nombre de version pour un seul contenu, donc plus de stockage de données.

1.2 Concept

L’Audio Orienté Objet (OBA pour Object Based Audio, ou encore NGA Next Generation Audio), a l’ambition d’adapter un contenu audiovisuel, en fonction du spectateur et du contexte de diffusion. Cela est rendu possible en repensant la spatialisation. Au lieu, de dispatcher les sources sur différentes enceintes (principe multicanal classique), de spatialiser avec un potentiomètre de panoramique classique Δi, le son est ici assigné à des metadatas, des données de position (azimut, élévation, distance) et de gain. Ces données sont stockées dans un fichier XML, qui seront lues en même temps que le fichier sonore.

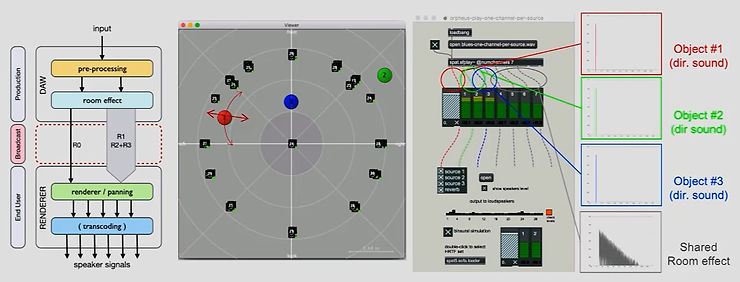

Représentation de la chaîne audio Orienté Objet

(source cliquable)

Avec ces données de spatialisation bien plus précises, il peut intégrer également des informations techniques sur le format, le nom et type de son, ou encore les langues audio disponibles etc. Ces fichiers XML et audio, sont encapsulés dans un fichier BWF (Broadcast Wave Format). Le projet est alors universel et peut s’adapter aux formats cinéma (Dolby, DTS, NHK 22.2, Auro 3D) et à n’importe quelle situation ou se trouve le spectateur. Le temps consacré à d’adaptation du contenu est alors révolu.

En plus de tout simplifier en un seul format, l’Orienté Objet permet d’obtenir un son interactif, personnalisé et plus d’accès à une immersion sonore. L’utilisateur pourra non seulement avoir accès simplement à différents formats audio en fonction de ses besoins (5.1 pour un home cinéma, binaural pour le casque, simple stéréo,…) mais aussi choisir ce qu’il veut entendre, étant donné que ce sont plusieurs matières sonores individuelles, qui sont lues en même temps. Il sera alors possible d’augmenter la voix d’un présentateur de sport ou ne garder que l’ambiance d’un stade. N’écouter que l’instrumental d’une musique pour un cover,...

Interface de réglage audio pour un contenu MPEG-H

“Le NGA est plus efficace en termes de débit binaire que les technologies précédentes, de sorte que ces nouvelles fonctionnalités ne se font pas au prix de débits binaires plus élevés."

tech.ebu.ch/nga

20 professionnels de l’audio ont participé à un petit sondage réalisé lors d’un séminaire à Genève le 17 et 18 Mai 2017, présentant les avancées d’ORPHEUS sur l’audio basé sur objet, sur la question “Quelle fonctionnalité est la plus importante selon vous?” (visible ci-dessous). En première position arrive la compréhension des dialogues, en deuxième la sélection des formats (7.1, 5.1, binaural, stereo,...), en troisième la localisation. Vint ensuite le contrôle de la plage dynamique, la sélection des langues, et les metadata du programme.

En vu du contexte d’aujourd’hui, avec la forte croissance du podcast, de la vidéo à la demande, en recherche de nouvelles expériences audiovisuelles, accessibles simplement, l’Orienté Objet semble tomber à pic. Les applications et améliorations sont nombreuses.

La première solution pour spatialiser de l’audio est de l’assigner à une enceinte, située à un point précis. Le nombre de canaux audio correspondent alors au nombre d’enceintes du système d’écoute prévu (stéréo, 5.1, 7.1,...). Cette méthode fonctionne à condition de respecter les normes de diffusion prévues pour le contenu. Si les enceintes sont positionnées différemment de la norme de mixage, les informations de spatialisation seront altérées, moins réalistes donc moins immersives. Le média devra en temps normal être ré-adapté pour être compatible sur un autre système de diffusion (downmix 5.1 vers stereo par exemple). En assignant de l’audio comme étant “channel based”, il sera considéré comme objet fixe, et se verra appliqué ses données de positions, pour pouvoir être compatible sans modification supplémentaire.

Pour une captation d’ambiance en quadriphonie, on la définira en post-production comme étant “channel based”. Chaque canal individuel aura alors son code et ses informations précises. Le canal gauche L aura la donnée d’azimut -30°, droite R +30°, arrière gauche LS -110°, et arrière droite LR +110°.

(Ces coordonnées sphériques pourront être retranscrites en coordonnées cartésiennes si besoin pour d’autres lecteurs).

L’audio Orienté Scène est une autre approche de l’ambiance spatialisée. Elle fait directement référence à l’Ambisonique, qui est une méthode de captation 3D à un point précis de la scène sonore. Elle s’appuie sur la superposition de plusieurs microphones, et des harmoniques sphériques.

L’ordre correspond au nombre de capteurs utilisés par le système, plus l’ordre est élevé, plus la restitution spatiale est précise. Le FOA (first Order Ambisonic, ordre 1) a trois directivités et utilisera quatres pistes. Le plus utilisé est l’ordre 3 (TOA), pour sa bonne restitution spatiale et spectrale (restitution des signaux HOA sur des Haut-Parleurs en annexe figure A2).

En plus de contenir beaucoup plus de pistes (au-delà de seize) les ordres supérieurs au TOA peuvent contenir des défauts spectraux et de corrélation de phases, car ils utilisent plus de microphones. Différentes marques proposent des micros ambisonic comme SoundField (racheté par RODE), ou Sennheiser avec l’AMBEO.

Une fois la captation réalisée (format A), il faut dématricer le signal (format B), une manipulation des cosinus, sinus, mixage est effectué afin d’obtenir les données X,Y, Z, etc. L’ Ambisonique est également très utilisée comme encodeur et décodeur, pour du binaural de synthèse par exemple, nécessitant une spatialisation 3D précise.

1.3.3 Audio “Orienté Objet” (Object Based)

Un objet désigne un son seul, ayant une position sous forme d’azimut et d’élévation, connaissant une variante temporelle, qui se déplace dans la scène sonore. Ils peuvent être plusieurs à constituer une scène. Étant un format indépendant du système d'écoute, l’ambisonique peut être exporté en object based. Chaque objet possède son canal de mixage et ses métadonnées. En plus des données de position, des paramètres sur la taille de l’objet donnant un son plus ou moins directif sont possible. Le moteur de rendu recevra alors l’info d’envoyer le son à l’enceinte la plus proche ou à un ensemble d’enceintes. Le paramètre “Object Divergence” allant de 0 à 1 permet la création d’objet fantôme, à 45° (si l’on utilise les coordonnées sphérique) à gauche et à droite de l’objet d’origine. C’est le même principe que le potentiomètre “center%” dans le pan 5.1 de Pro Tools.

Chaque audio décrit comporte un identifiant, un code avec des informations sur son format, la localisation du fichier, la langue associée, ou encore la durée du programme, pouvant proposer le même contenu avec plusieurs longueurs selon le temps dont dispose l’auditeur. (Les métadonnées sur la diégèse du son pour du contenu VR ne sont pas spécifiées par l’ADM).

L’audio Object Interaction définit les limites de l’interaction accordé à l’auditeur. Si le programme à l’indicateur 1, il accorde une certaine liberté de modification sur le gain ou la localisation des sons.

Si l’interaction sur le gain est autorisée, le sous élément “Audio Object Interaction” donne une intervalle limite ou une liberté totale. L’auditeur pourra si il le souhaite, n’entendre que l’ambiance du match par exemple.

Si l’interaction sur la position est autorisée, le sous élément “Audio Object Interaction” donne une intervalle limite sur l’azimut, l’élévation et la distance (données Sphériques ou Cartésiennes).

1.3 ADM (Audio Definition Model norme ITU-R BS.2076-2)

L’Audio Definition Model (ITU-R BS.2076-2) est une norme de metadata pour l’audio Objet, élaboré et standardisé en juin 2017 par l’Union Européenne de Radio Télévision (UER EBU), avec le soutien de la BBC, France TV, Radio France et Fraunhofer. Ce standard européen ouvert et gratuit, est le plus avancé sur les metadatas de l’audio nouvel génération (NGA) (Document complet de la norme ADM disponible ici et plus d'information en annexe A).

Affiliant des données XML à l’audio, l’ADM différencie les éléments du paysage sonore afin de définir un fichier audio comme étant “Channel Based”, “Scene Based”, “Object Based” Audio.

1.3.1 Audio “Orienté canal” (Channel Based)

1.3.2 Audio “Orienté Scène” (Scene Based)

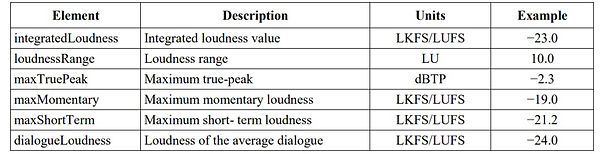

1.4 Fonctionnalités de l’ADM

1.4.1 Les Fonctions d’adaptations de l’ADM

Une fois l’audio référencé, plusieurs paramètres entrent également en compte. La “Zone d'exclusion” définit les différentes limites de l’espace 3D (avec des données cartésiennes X,Y,Z) afin de masquer dynamiquement les points de sources à ne pas utiliser pendant la lecture. Les données nommées “Audio Programme Reference Screen”, elles, indiquent les références de l’écran utilisé par le créateur de contenu. Ces coordonnées (Polaire ou cartésiennes) peuvent influer sur la spatialisation, et permettent l’adaptabilité spatiale du projet. Si par exemple le contenu contient l’indicateur “ScreenRef Flag”, informant que l’audio Orienté Scène (Scene Based) est lié à la taille de l’écran, le moteur de rendu adaptera la scène au système de la salle recevant le contenu.

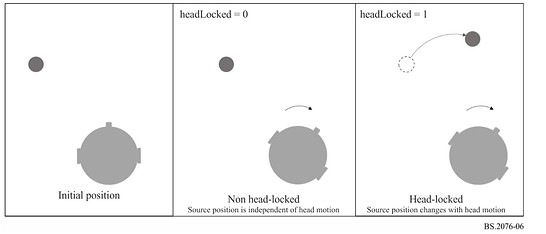

Pour ce qui est de l’adaptation d’un contenu en Binaural, la fonction “Head Locked” définie si un objet doit bouger en fonction des mouvements de tête (ambiance par exemple), ou ne pas en prendre compte (voix off par exemple). Le contenu pourra être binauralisé par le moteur de rendu, donnant à l’auditeur le choix du ratio champs direct/champs réverbéré de l’acoustique virtualisé, et pourquoi pas des HRTF. La mesure du Loudness est effectuée avec la norme recommandée ITU-R BS.1770 fonctionnant pour les formats mono, stéréo, et multicanaux. (cf Annexe figures A4 et images ci-dessous). La norme EBU R128 est quant à elle utilisée pour le “Loudness Rec Type, afin d’indiquer quelle pratique a été suivie dans la correction du Loudness”; et enfin le “Loudness Correction Type” comment l’audio a été corrélé (temps réel ou hors ligne).

Représentation de la fonction Head Locked avec un Head Tracker. (ITU BS.2076-06)

Une matrice divisée en trois segments interconnectés (partie encodage, décodage et direct) effectuera les downmix/upmix, en se servant de la base de données et des identifiants de chaque piste. Des valeurs de gain et de déphasage peuvent être constantes ou variables pour permettre au moteur de rendu d’ajuster ces valeurs, possiblement avec une autre source de métadonnées. Des sous-éléments sont également disponibles pour choisir la définition de la conversion. Une fois que le contenu est au format ADM, tout l’audio est encapsulé dans un fichier BWF (Broadcast Wave Format), un simple fichier WAV contenant nos metadata XML.

1.4.2 Application de l’ADM

Orpheus est un projet faisant parti du programme “Horizon 2020” de la commission européenne, apportant 80 Milliards d’euros de financement dans la recherche et l’innovation en 7 ans. Le projet a été lancé le 1er Décembre 2015 et s’est achevé le 31 Mai 2018, il a été le premier à créer une chaîne multimédia de A à Z avec de l’audio Orienté Objet (vidéo montrée précédement en 1.2). Dix partenaires participeront à son élaboration dont Fraunhofer institute, la BBC, l’IRT, Magix (DAW Sequoia), Elephant Candy (pour la création d’une application ios), et aussi les français Trinnov, B-com, et l’IRCAM,...

l'Institut de Recherche et Coordination Acoustique/Musique, à créé le logiciel ADMix permettant de rendre un projet au format objet sous la norme ADM, mais aussi de le lire et d’extraire les données XML. D’autres DAW sont compatibles ADM tels que Pyramix ou Nuendo. La norme ADM vise à unifier les autres formats utilisant aussi le principe objet (Dolby, DTS, Fraunhofer,...), en misant sur la liberté, la transparence et la gratuité. Correspond t-elle à toutes les applications utilisées? Comment ces différents outils et formats objets communiquent-ils entre eux? C’est ce que nous essayerons de voir dans le chapitre 3 de ce mémoire.

1.4.3 La Question de la Réverbération

Le plus délicat dans la recherche de l’OBA, c’est la réverbération, qui n’est pas évoquée par la norme ADM. Ce phénomène acoustique généré par de multiples réflexions d’ondes sonore propre à un lieu, donnant une couleur et une nouvelle dimension au son direct, est indispensable pour le réalisme d’un contenu. Elle pourrait également offrir à l’auditeur une customisation de pièces, pour une immersion d’un contenu dans une salle de spectacle par exemple. Seulement, cet effet est complexe à référencer en objet, tout en gardant la qualité. Il est effectivement impensable d’utiliser un objet pour chaque réflexion acoustique.

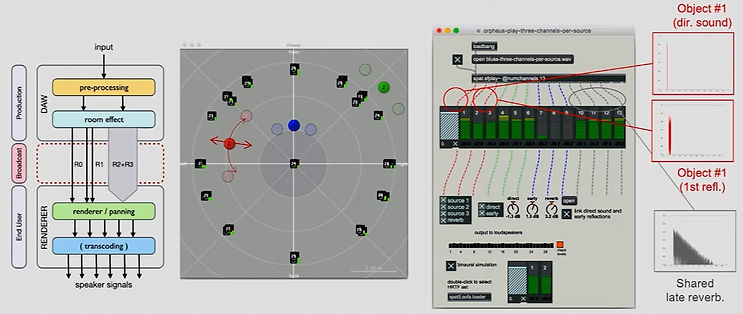

Certains membres de l’équipe ORPHEUS, Markus Noisternig et Olivier Warusfel de l’IRCAM, ont alors proposé une réflexion sur les techniques de réverbérations pour l’audio objet. Il existe deux approches afin d'intégrer la reverb à l’ADM.

La première est de convertir les paramètres de la reverb en metadata, ce qui impliquerait l'intégration d’un programme de reverb dans le moteur de rendu.

La deuxième est l’approche “basé signal”, étudiée par ORPHEUS et S3A Audio, qui utilise le principe Orienté Scène ou Canal. Dans cette approche, plusieurs méthodes sont possible:

-

Séparer complètement le son direct du son réverbéré

-

Avoir deux pistes pour le son direct et la première réflexion, puis les autres réflexions (plusieurs pistes)

-

Avoir trois pistes pour le son direct, la première et deuxième réflexion, puis les autres réflexions (plusieurs pistes)

Le moteur de rendu interprètera donc les metadata des différents canaux avec des informations de gain et de spatialisation. A défaut de demander plus de pistes contenant les premières réflexions, cette technique donne d’avantages de contrôle sur la localisation des sources.

Les difficultés sont aussi du point de vue de la différenciation entre le son direct et les première réflexions, ou encore l'intégration de la reverb pour les programmes à multi-languages. L’approfondissement et l’étude d’une extension se profilent donc pour le format ADM, afin de répondre à toutes ces questions.

Troisième méthode d’utilisation de la réverbération avec OBA

Comme dit précédemment, l’audio objet est un son accompagné de métadonnées qui le décrit (position, gain,...), ils seront lus en même temps lors de la restitution. L’ADM est d’ailleurs une proposition de norme décrivant ces métadonnées, présent de la production à la diffusion. Plusieurs solutions utilisent ce principe: le Dolby Atmos, le MDA de DTS, le MPEG-H de Fraunhofer, et enfin la technique WFS, nous les étudierons dans le chapitre 2.

Le 10.2 (de Tomlinson Holman, créateur de THX) l’auro 3D et le 22.2 de NHK sont quant à eux des normes de diffusion, surtout présents dans les salles de cinéma. Ils font référence à une diffusion multicanal, ou chaque son est assimilé à une ou plusieurs enceintes, et non à des métadonnées. Cela n'empêchera pas pour autant l’utilisation de ces systèmes de diffusion avec un contenu objet, capable de s’adapter.

Le binaural est aussi une méthode très intéressante, surtout sur le point de la diffusion pour l’audio objet. Cette technique utilise les données HRTF afin de rendre l’écoute d’un contenu plus naturelle, avec une localisation à trois dimensions, comme dans la vie de tous les jours. Le son 3D serait alors à portée de tous, nécessitant simplement un casque. Le moteur de rendu délivrant le contenu quelconque pourra restituer, après sélection de l’auditeur, le son 3D avec les informations de la matrice et les paramètres de binauralisation de l’audio instauré. Le binaural peut également servir à simuler l’écoute en auditorium ou d’une salle de cinéma pour le mixage d’un film. Cette pratique faisait partie du projet de recherche BILI (BInaural LIstening), lancé en Janvier 2013, en partenariat avec l’IRCAM, France Télévision, Radio France et Trinnov entre autre.